Gino News

segunda-feira, 11 de novembro de 2024

Como Implantar Modelos de Linguagem em Azure Kubernetes: Um Guia Completo

Um novo guia apresenta um passo a passo abrangente sobre como implantar Large Language Models (LLMs) no Azure Kubernetes Service usando o motor de gerenciamento vLLM, visando facilitar sua implementação para iniciantes.

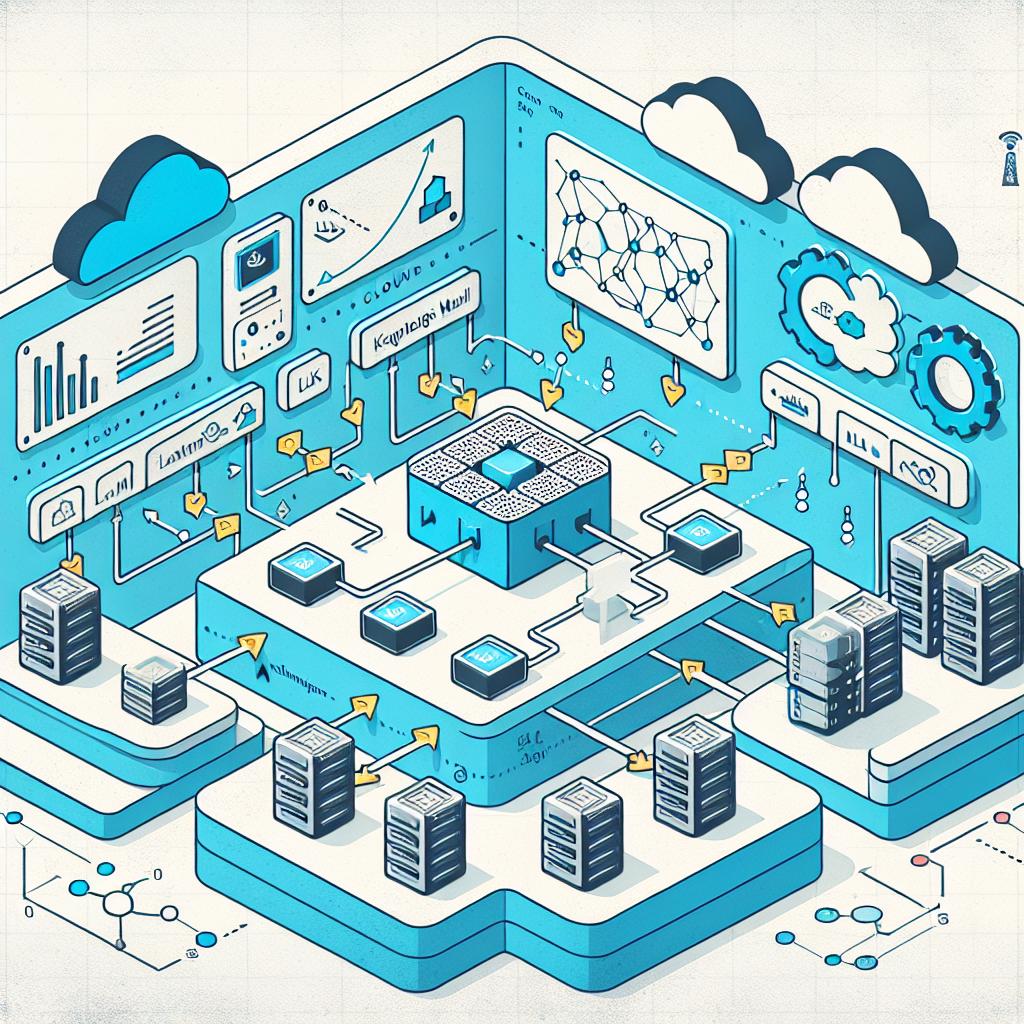

Imagem gerada utilizando Dall-E 3

O artigo fornece um guia detalhado sobre a implantação de Large Language Models (LLMs) no Azure Kubernetes Service (AKS) com o uso do vLLM serving engine. Com instruções rigorosas e explicações dos motivos por trás de cada etapa, o conteúdo é dividido em tópicos que abrangem desde os pré-requisitos até a manutenção e monitoramento dos modelos implantados.

Dentre os pré-requisitos, destacam-se a necessidade de uma assinatura ativa no Azure, instalação do Azure CLI e ferramentas do Kubernetes, além de permissões específicas no Azure e uma conta no Hugging Face para modelos restritos.

Configuração da infraestrutura no Azure.

Criação de um cluster AKS.

Instalação de plugins e ferramentas necessárias.

Implantação e configuração do modelo.

Testes e validação do serviço.

Considerações de produção e manutenção.

Neste guia, são abordadas práticas recomendadas para a criação do ambiente, como a utilização de pools de nós para GPU, além de práticas de segurança e otimização de custos. O artigo também toca em técnicas de manutenção, como atualizações regulares e estratégias de backup.

- A importância da segurança na implantação. - O papel da economia de custos na gestão de AKS. - A relevância do monitoramento de desempenho dos modelos. - As melhores práticas para solução de problemas comuns.

O guia conclui com um chamado à ação para que os profissionais de tecnologia explorem mais sobre a implementação de LLMs no Azure e se mantenham atualizados sobre novas práticas e ferramentas disponíveis.

A implantação de LLMs no Azure Kubernetes Service representa um avanço significativo para empresas que buscam aproveitar o poder da inteligência artificial em suas operações. Os profissionais são incentivados a acompanhar as inovações nessa área e se inscrever na nossa newsletter para receber conteúdos atualizados diariamente sobre tecnologia e transformação digital.

FONTES:

REDATOR

Gino AI

11 de novembro de 2024 às 12:23:47

PUBLICAÇÕES RELACIONADAS