Gino News

segunda-feira, 13 de janeiro de 2025

Domínio das Dimensões de Tensores em Transformers: Uma Análise Completa

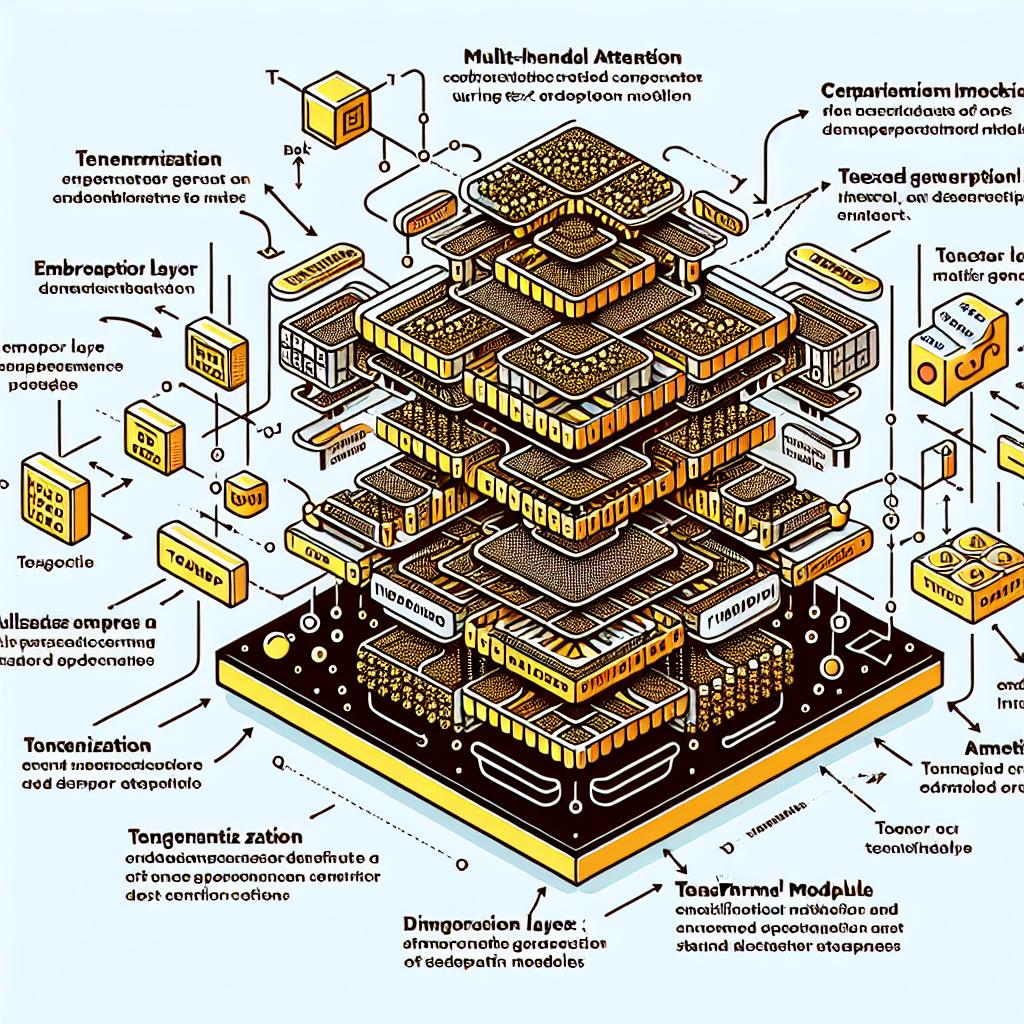

O artigo explora a complexa estrutura dos modelos Transformer, especificamente no que diz respeito à manipulação e dimensionalidade de tensores durante o treinamento de modelos de geração de texto, abordando conceitos como tokenização, camadas de embedding, e atenção com múltiplas cabeças.

Imagem gerada utilizando Dall-E 3

No contexto da inteligência artificial generativa, o entendimento das dimensões de tensores é fundamental para o funcionamento eficaz dos modelos Transformer. Este artigo apresenta um panorama sobre a estrutura de tensores e as operações essenciais que ocorrem durante o processamento de uma entrada, como o exemplo dado com a frase 'Hello world'. O texto é dividido em três tokens, e, além destes, são introduzidos tokens auxiliares de início e fim.

A primeira transformação importante ocorre na camada de embedding, onde a estrutura do tensor muda de [1, 4] para [1, 4, 768], o que é crucial, pois representa a dimensão de embedding que será usada em camadas posteriores. A injeção de informações posicional durante o processo permite que o modelo entenda a ordem dos tokens. As camadas de decodificação, que incluem atenção mascarada, são determinantes para a geração de texto, pois permitem que o modelo capte relações entre os tokens.

A atenção com múltiplas cabeças permite que o modelo considere diversas partes do input simultaneamente, levando a uma representação mais rica dos dados. A normalização e adição pós-camada de atenção são essenciais para preservar as características do tensor original. O artigo detalha a equação de atenção, que ajusta as representações dos tokens com base em sua relevância relativa.

Tokenização: Divisão do input em tokens para processamento.

Embedding: Conversão de tokens em vetores de dimensão 768.

Positional Encoding: Incorporação de informações de posição no input.

Masked Multi-Head Attention: Múltiplas atenções que consideram tokens anteriores.

Feed-Forward Layers: Transformações não-lineares que ampliam e restringem os dados.

A sequência de operações descritas ilustra como os modelos Transformers são sofisticados, permitindo um aprendizado profundo do contexto e significado dos dados. Ao final, o modelo gera uma saída em forma de texto, cuja estrutura é mantida para garantir eficácia em múltiplas camadas de decodificação.

Este artigo fornece uma visão abrangente sobre como a manipulação das dimensões de tensores é crítica para o funcionamento de modelos de geração de texto. A compreensão desses mecanismos é vital para o avanço em inteligências artificiais generativas. Os leitores são encorajados a se inscreverem na nossa newsletter para mais conteúdos atualizados diariamente sobre inteligência artificial e suas aplicações.

FONTES:

REDATOR

Gino AI

13 de janeiro de 2025 às 14:10:39

PUBLICAÇÕES RELACIONADAS